Bereits über vier Fünftel aller Anwender solcher Plattformen schätzen ihre Organisation als gut auf den Wegfall von Third-Party-Cookies vorbereitet ein . Nur im Zusammenspiel dieser drei elementaren Bausteine lassen sich hochgradig personalisierte Kundenansprachen, automatisierte Customer-Journeys und belastbare Analysen realisieren, die nachhaltig Wettbewerbsvorteile sichern.

Vor jeder technischen Auswahl steht die präzise Definition der Geschäftsanforderungen. Es gilt, den Zweck der Lösung ebenso festzulegen wie die anzubindenden Prozesse: Geht es primär um Lead-Generierung, Prognosen für den Vertrieb oder die Optimierung von Service-Abläufen?

Eng damit verbunden ist die Frage nach Offenheit und Schnittstellenfähigkeit der Plattform gegenüber bestehenden Systemen, insbesondere hinsichtlich einheitlicher Programmierschnittstellen und zuverlässiger Konnektoren. Nicht minder wichtig sind eine intuitive Bedienbarkeit und ausgefeilte Sicherheitskonzepte, die alle Anforderungen an Datenschutz und Compliance abdecken. Eine strukturierte Marktanalyse, ergänzt um eine Shortlist geeigneter Lösungen, legt die Grundlage für einen praxisorientierten Proof-of-Concept, in dessen Rahmen realitätsnahe Workflows abgebildet, Usability überprüft und Integrationsszenarien getestet werden. Bereits an dieser Stelle empfiehlt sich eine frühzeitige Klärung von Service-Level-Agreements, Support-Level und Lizenzmodellen, damit unerwartete Kostensteigerungen im Betrieb ausgeschlossen bleiben.

Parallel dazu ist eine gründliche Prozess- und Datenanalyse unverzichtbar. In gemeinsamen Workshops der internen Stakeholder werden alle kundenrelevanten Touchpoints in Vertrieb, Marketing und Service systematisch erfasst. Eine vollständige Inventur bestehender Kundendatenquellen – von ERP-Systemen über Tabellenkalkulationen bis hin zu bestehenden Automatisierungs- und Tracking-Lösungen – schafft Transparenz über Datenlage und -qualität. Auf dieser Basis lassen sich Zielprozesse definieren, Datenmodelle vereinheitlichen und Feldstandards festlegen. Ein abgestimmtes Change-Management-Konzept stellt sicher, dass Key-User frühzeitig eingebunden, Kommunikationsmaßnahmen zielgerichtet gesteuert und Schulungsprogramme passgenau erstellt werden. Zahlreiche Fallstudien belegen, dass mangelhafte Vorbereitung im Bereich Datenmanagement zu erheblichen Verzögerungen und Akzeptanzproblemen führen kann .

Erst nachdem Prozesse und Dateninventur abgeschlossen sind, gewinnt das Thema Data Governance an Kontur. Ein professionelles Governance-Framework definiert Rollen und Verantwortlichkeiten für alle Aufgaben rund um Datenqualität, Sicherheit und Compliance. Richtlinien zu Felddefinitionen, Validierungsregeln und Dublettenmanagement werden ebenso festgelegt wie Abläufe für die Datenfreigabe und -archivierung. Metadaten-Management sichert eine einheitliche Dokumentation aller Datenattribute und legt damit die Basis für transparente Audits und regulatorische Prüfungen .

Die Vorteile liegen auf der Hand: Hochwertige Daten steigern die Qualität von Analysen und KI-basierten Prognosen, verringern den Aufwand für manuelle Korrekturen und schaffen Vertrauen bei Stakeholdern.

Eng verknüpft mit der Governance ist ein systematisches Data-Cleansing. Dubletten werden identifiziert und anhand eindeutiger Kriterien wie E-Mail-Adresse oder Kundennummer zusammengeführt, fehlende Informationen durch seriöse Drittquellen angereichert und alle Datensätze automatisiert auf Konsistenz geprüft. Kontinuierliche Qualitätsscans und Dashboards sorgen dafür, dass die Datenbasis dauerhaft stabil bleibt und jederzeit belastbare Entscheidungen ermöglicht .

Eine zentrale Rolle nimmt der Aufbau eines unternehmensweiten Data Layer ein. Dieser fungiert als standardisierte, semantische Abstraktionsschicht im Frontend, in die jede Nutzerinteraktion an einer zentralen Stelle eingespielt wird. Semantisch konsistente Feldbezeichnungen und ein klar definiertes Namensschema verhindern Inkonsistenzen und erleichtern allen nachgelagerten Systemen den Zugriff auf identische Datenströme. Die Entkopplung des Frontends von den Integrationen gewährleistet, dass neben der Echtzeit-Erfassung auch die Flexibilität für künftige Erweiterungen gegeben ist. Jeder Event-Datensatz durchläuft automatisierte Health-Checks, die Unregelmäßigkeiten umgehend melden und Data Stewards ermöglichen, schnell gegenzusteuern .

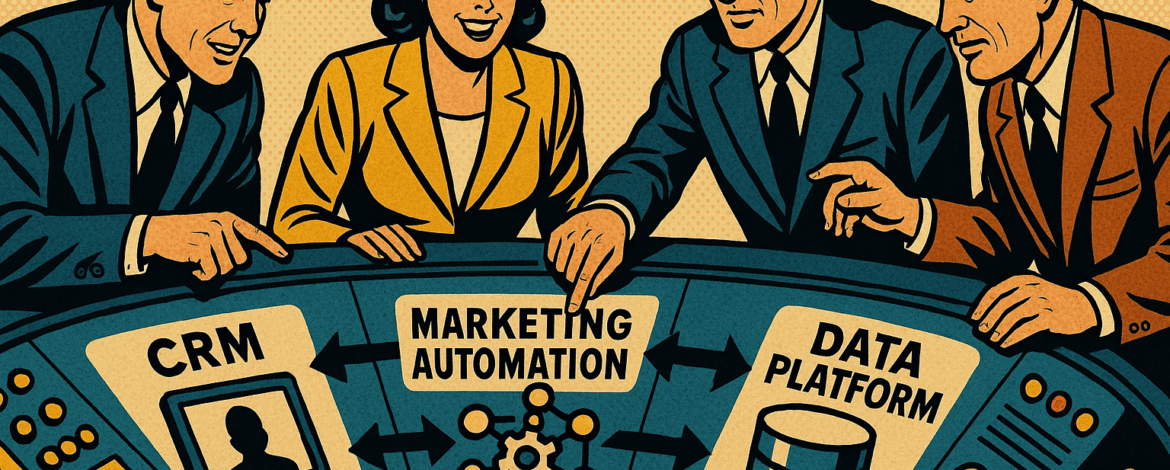

Erst wenn die Datenbereitstellung im Data Layer sichergestellt ist, entfaltet die Kombination aus Kundenverwaltungsplattform, Automatisierungsumgebung und Datenplattform ihre volle Kraft. Die Kundenverwaltungsplattform fungiert als Quelle für Stammdaten, Kontakte, Leads und Opportunitys, während die Automatisierungsumgebung auf diesen Datensätzen automatisierte, mehrstufige Kampagnen ausspielt und mithilfe von A/B-Tests deren Effizienz steigert. Parallel dazu aggregiert die Datenplattform alle relevanten Informationen in einem 360-Grad-Profil, gesteuert durch eindeutiges Einwilligungs- und Berechtigungsmanagement. Die so erzielten Echtzeit-Segmente ermöglichen hochgradig präzise Aussteuerung in den Automatisierungsabläufen und liefern zugleich wertvolle Insights für den Vertrieb und das Controlling.

Ohne Plan geht es nicht zum Ziel. Der optimale Shortcut zum zukunftsfähigen Techstack

Für die Umsetzung empfiehlt sich ein klar strukturierter Projektplan, der sich idealtypisch an einem Zeitraum von zwölf Monaten orientiert. Zwei Wochen vor Projektstart dienen der finalen Ist-Analyse und der Dateninventur. Im Anschluss gliedern sich Auswahl und Proof-of-Concept über einen Monat, gefolgt von acht Wochen Design und Konfiguration der Datenmodelle sowie der Data-Layer-Spezifikation. Die anschließende Entwicklungs- und Integrationsphase umfasst weitere acht Wochen, in denen die erforderlichen Schnittstellen und Konnektoren entstehen. Einen Monat später beginnt die Phase des Data-Cleansing und der Migration historischer Datenbestände, bevor in vier Wochen End-to-End-Tests, Sicherheitsprüfungen und Abnahmetests erfolgen. Es folgen zwei Wochen Roll-Out mit begleitenden Schulungen sowie eine achtwöchige Stabilisierungsphase, in der Monitoring und Optimierung im Fokus stehen. Abschließend werden in weiteren acht Wochen erweiterte Automatisierungen implementiert, KI-Use Cases realisiert und Reportings optimiert.

Nur wer strukturierte Planung, stringente Governance und akkurates Data-Cleansing mit einer soliden technischen Basis kombiniert, schafft nachhaltige, skalierbare Customer-Engagement-Strukturen. Ein solcher Ansatz versetzt Unternehmen in die Lage, datengetriebene Prozesse nicht nur zu steuern, sondern digitale Kundenerlebnisse zu antizipieren und damit ihre Marktführerschaft langfristig zu sichern.